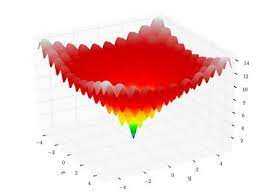

La optimización continua significa encontrar el valor mínimo o máximo de una función de una o muchas variables reales, sujeto a restricciones. Las restricciones generalmente toman la forma de ecuaciones o desigualdades. La optimización continua ha sido objeto de estudio de matemáticos desde Newton, Lagrange y Bernoulli.

- ¿Qué es una variable continua en la optimización??

- ¿Qué es la optimización discreta y continua??

- ¿Qué está optimizando una función??

- ¿Cuáles son los dos tipos de optimización??

¿Qué es una variable continua en la optimización??

La optimización continua es una rama de la optimización en matemáticas aplicadas. En oposición a la optimización discreta, las variables utilizadas en la función objetivo deben ser variables continuas, es decir, para ser elegidas de un conjunto de valores reales entre los cuales no hay brechas (valores de intervalos de la línea real).

¿Qué es la optimización discreta y continua??

En la optimización discreta, algunas o todas las variables en un modelo deben pertenecer a un conjunto discreto; Esto contrasta con la optimización continua en la que las variables pueden asumir cualquier valor dentro de un rango de valores.

¿Qué está optimizando una función??

Matemáticamente hablando, la optimización es la minimización o la maximización de una función sujeta a restricciones en sus variables.

¿Cuáles son los dos tipos de optimización??

Podemos distinguir entre dos tipos diferentes de métodos de optimización: métodos de optimización exactos que garantizan encontrar una solución óptima y métodos de optimización heurística donde no tenemos garantía de que se encuentre una solución óptima.

Howtosignalprocessing

Howtosignalprocessing